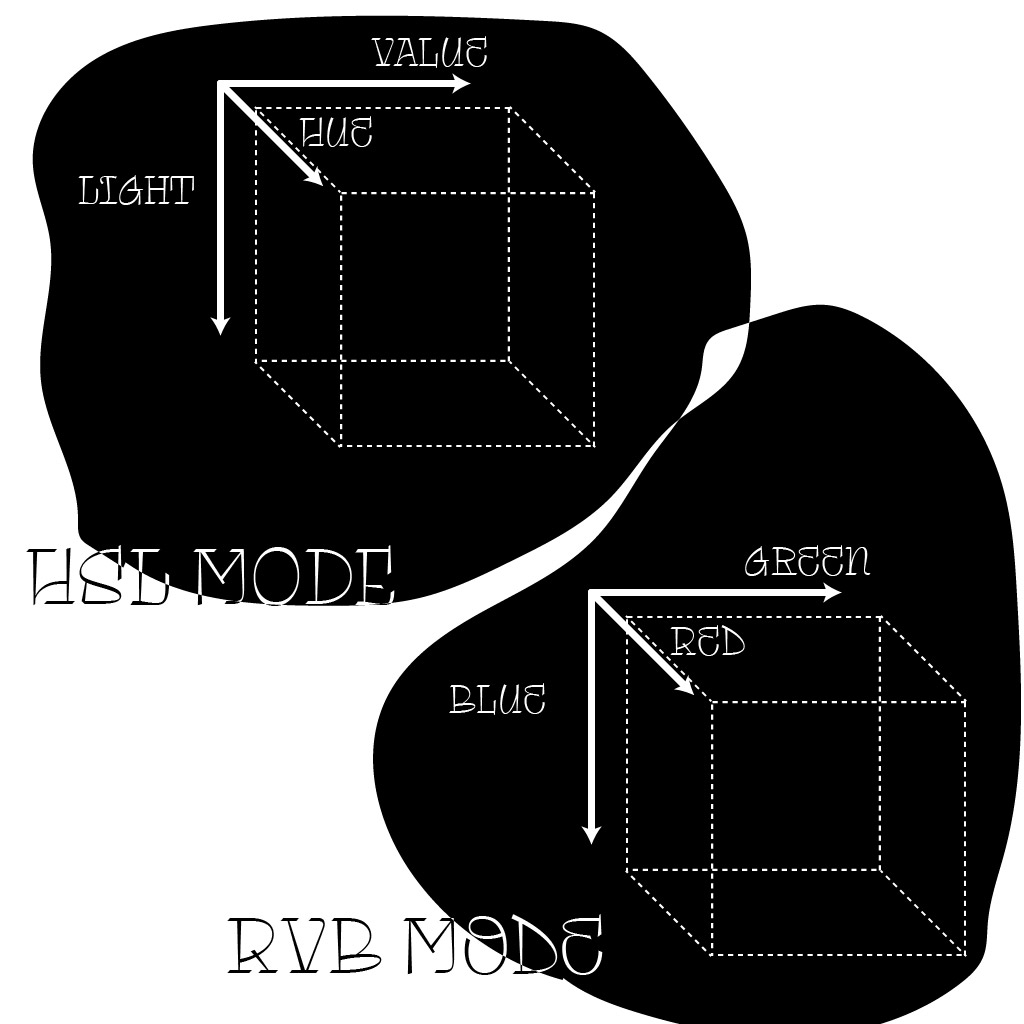

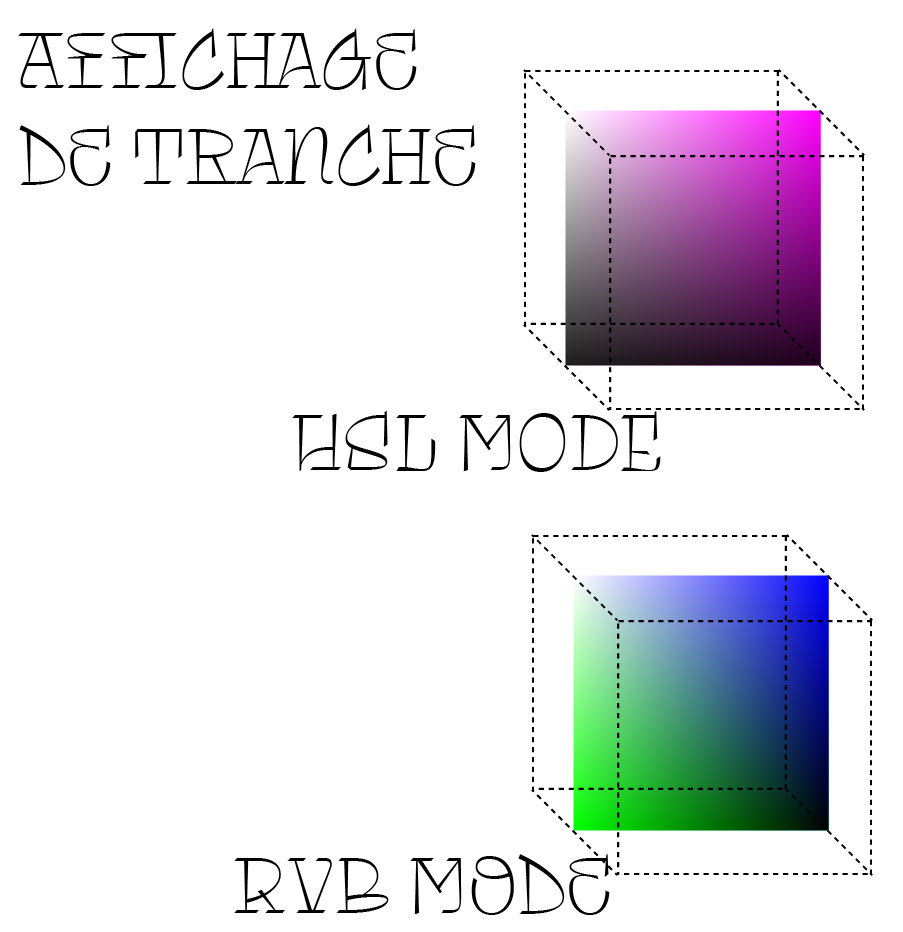

Suite des questionnements évoqués dans cet article. J’avais réalisé des tentatives d’interfaces pour rendre compte des composants permettant dans une interface de choisir une couleur, les colors pickers. Ainsi par mon analyse, j’avais interprété cette interface comme un sliders à trois dimensions. Ainsi on peut circonscrire ces choix de couleurs à un cube où les dimensions sont associées à un paramètre de la couleur. J’ai tenté cette suite avec deux modes colorimétriques : un RVB montrant comment la couleur est « réellement » rendu par un écran et en HSL – HVL (Hue Saturation/Value, Light), un mode colorimétrique plutôt employé pour les color picker 2D car il permet de plus « facilement » choisir une couleur.

Avec les tests effectués je me suis rendu compte que cette interface allait avoir besoin d’une « vue en tranche » de la couleur, car c’est assez compliqué de saisir le positionnement de notre main.

Les deux extraits vidéos présentent ainsi ces fonctionnements de composant d’interface. Dans l’état ils sont utilisables. J’avais pensé produire une version sphérique, décliner ce système sur d’autres formes primitives en 3d.

Moduler les vertex

Toutes les tentatives de modifier les rendus graphiques avec des gestes et mouvements, modifiaient les couleurs et matières de l’environnement, j’ai ainsi produit une petite déclinaison pour observer des modifications dans les vertex (avec les vertex shaders), c’est à dire des modifications dans la géométrie des modèles 3d.

Comment se mouvoir ?

Ces expérimentations avaient été initié par l’annonce du vision pro d’Apple, et par le fait que celui-ci n’intègre pas de manette (de controller), toutes les interactions passent par le regard et les mains de l’utilisateur-trice. Donc mes ébauches d’interfaces et de graphisme en réalité virtuelle utilisant les manettes comme input d’interaction deviennent caducs.

Mais à mon sens, des interfaces spatialisées et univers VR doivent permettre de se déplacer dedans, or les manettes offraient la possibilité de se déplacer à l’aide d’un joystick soit par un contrôle direct (en poussant le joystick vers l’avant, on va de l’avant), soit par un système de « canne à pêche ». Or le hand tracking n’intègre pas de joystick.

Pour contrer l’absence de joystick j’ai réalisé quelques expérimentations sur le déplacement en VR avec le hand tracking. Ainsi dans cette scénette, le mouvement des mains lors d’un déplacement est repris pour appliquer une vélocité sur le personnage : plus on bouge nos mains vite, plus on va vite !

C’est assez intuitif et fun, mais gimmick et relativement fatiguant. c’est certainement pas une interaction d’interface mais plutôt comme une mécanique pour un jeu vidéo.

Puis dans ce dernier exemple on se meut en pinçant dans le vide et cela nous déplace dans la direction de la main pinçant. en pinçant avec nos deux mains dans le même sens l’on va à la vitesse maximum. On flotte dans l’espace, j’ai appelé cette mécanique la locomotion superman, en tendant les bras on avance dans leur direction à la manière du super héro qui vole bras tendus.

Ces deux mécaniques, je les ai avant tout testé sur moi, or je ne présente que très peu de motion sickness, c’est à dire de mal de mer lors de déplacement en vr (lorsque l’on se déplace dans le virtuel mais pas dans le réel). Les mécanique « classique » dans les jeux en vr intègre justement un déplacement au joystick et un à la canne à pèche pour des raisons d’accessibilité : le joystick est plus intuitif mais la canne à pèche téléporte et prévient d’éventuels motion sickness. Aucune des deux expérimentations ne prend en compte le motion sickness.

Les expérimentations sont téléchargeables ici