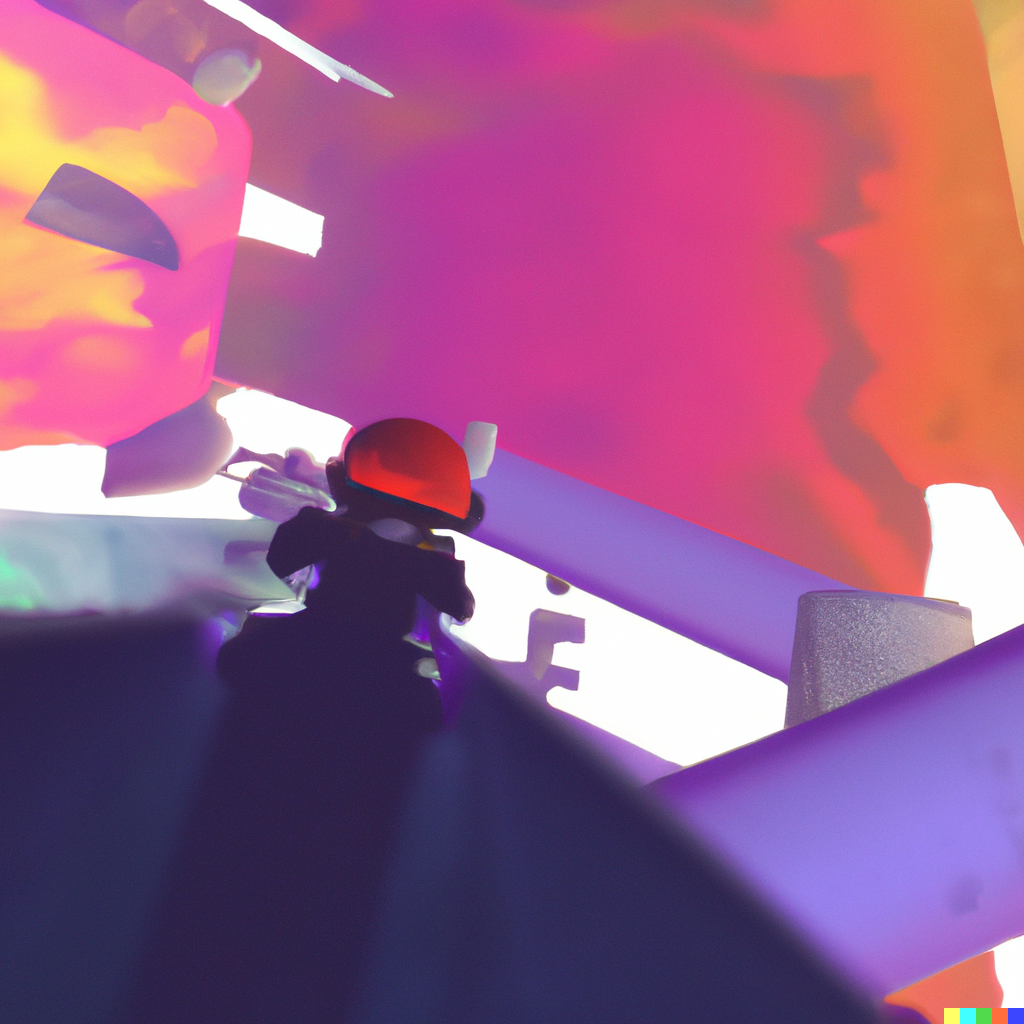

Le 19 juin, j’ai reçu une invitation pour la beta ouverte de DALL•E après plusieurs mois dans une liste d’attente. Cet outil de génération d’images utilisant les dernières technologies de deep learning, permet donc de générer des images à partir d’un texte — on demande à l’algorithme de générer telle ou telle forme — mais aussi de produire une déclinaison — on donne à l’algorithme une image et il en produit des déclinaison.

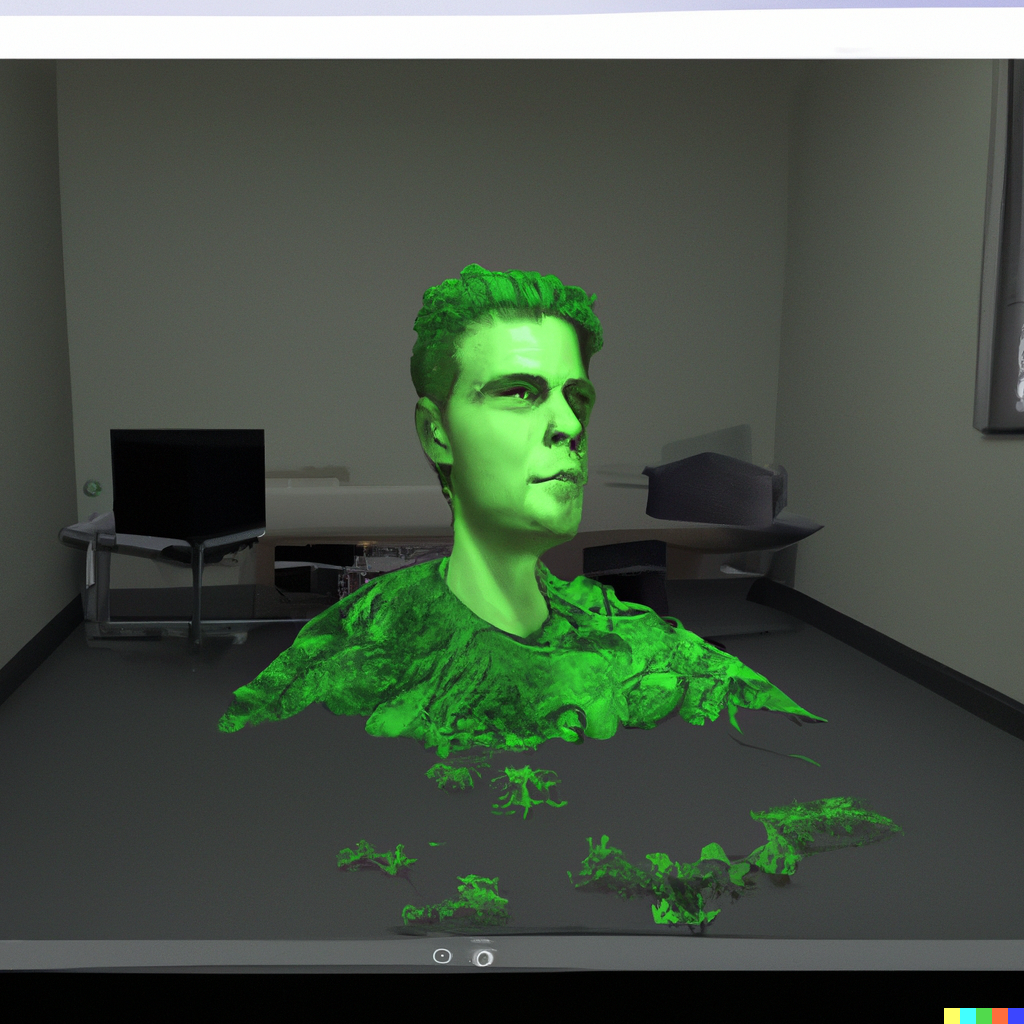

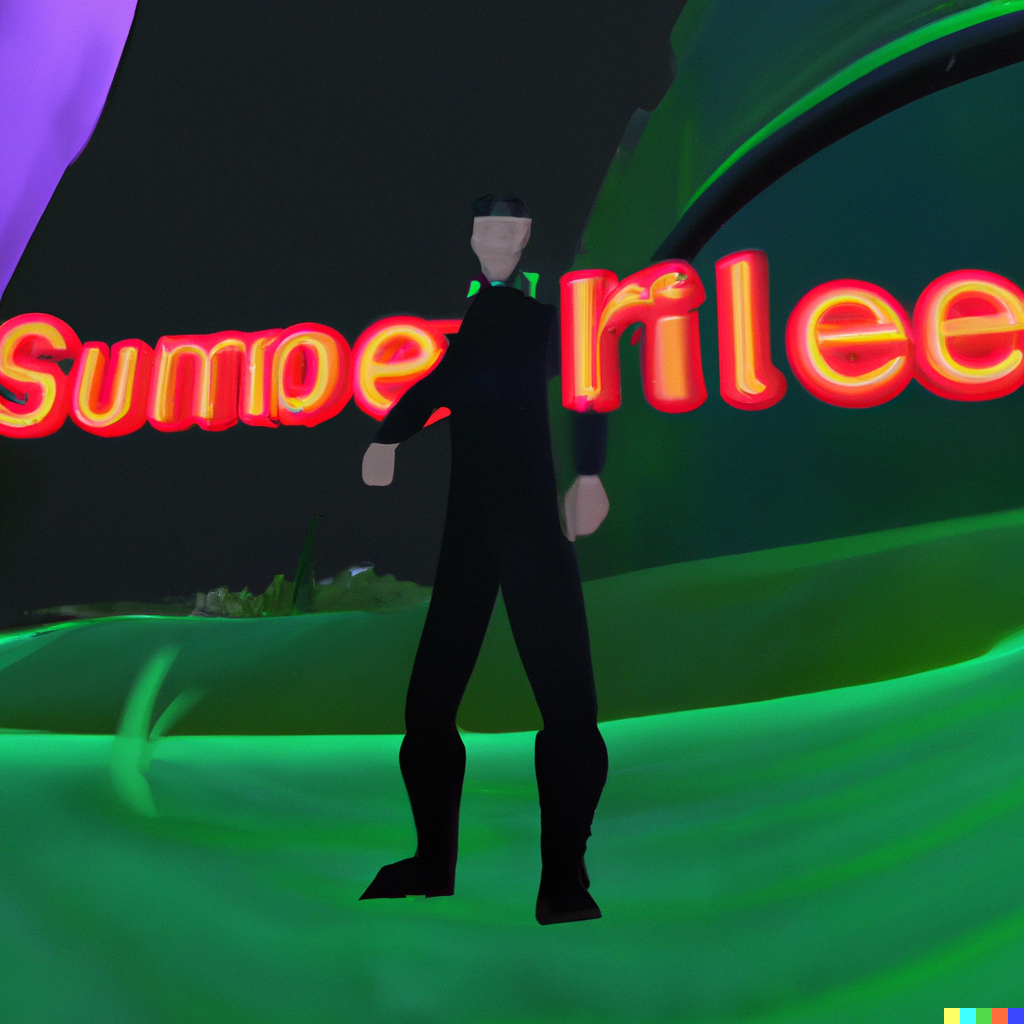

À la mi-juin je venais de finir mon diplôme de DNSEP en communication graphique à la HEAR, il portait sur l’usage d’algorithme de deep learning pour produire des formes et des univers. La pièce la plus importante de mon diplôme était un jeu vidéo en réalité virtuelle dans un univers « produit » par des IAs. J’ai donc composé des espaces virtuels avec des décors issus d’algorithme (ciel en deep dream, bâtiments en photogrametries etc…), puis je me suis dit pourquoi pas demander à DALL•E de décliner ces images et d’avoir une forme de retour sur comment une IA aurait réaliser ces univers ?

J’ai produit des formes spéculatives sur ce que serait un monde produit par des IAs puis je questionne une IA pour qu’elle produise ce qu’elle aurait voulu « voir ».

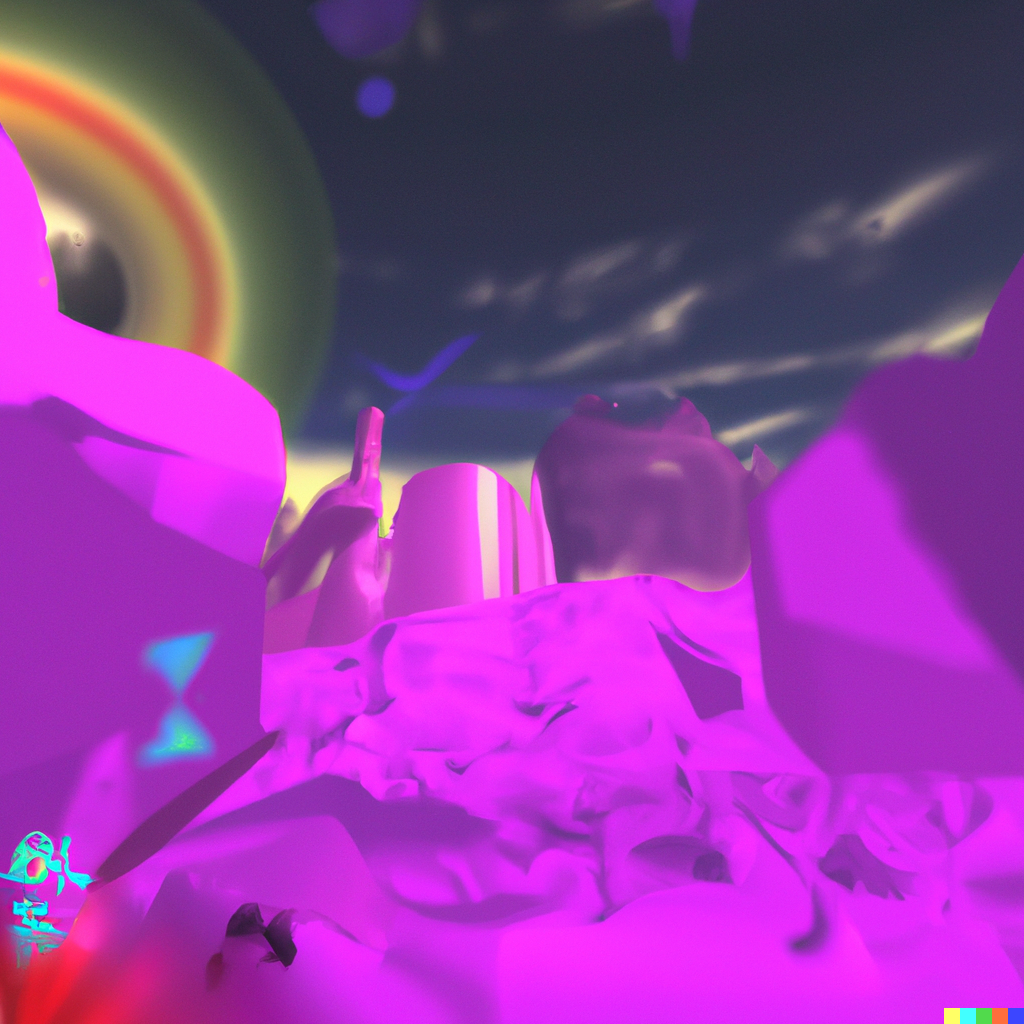

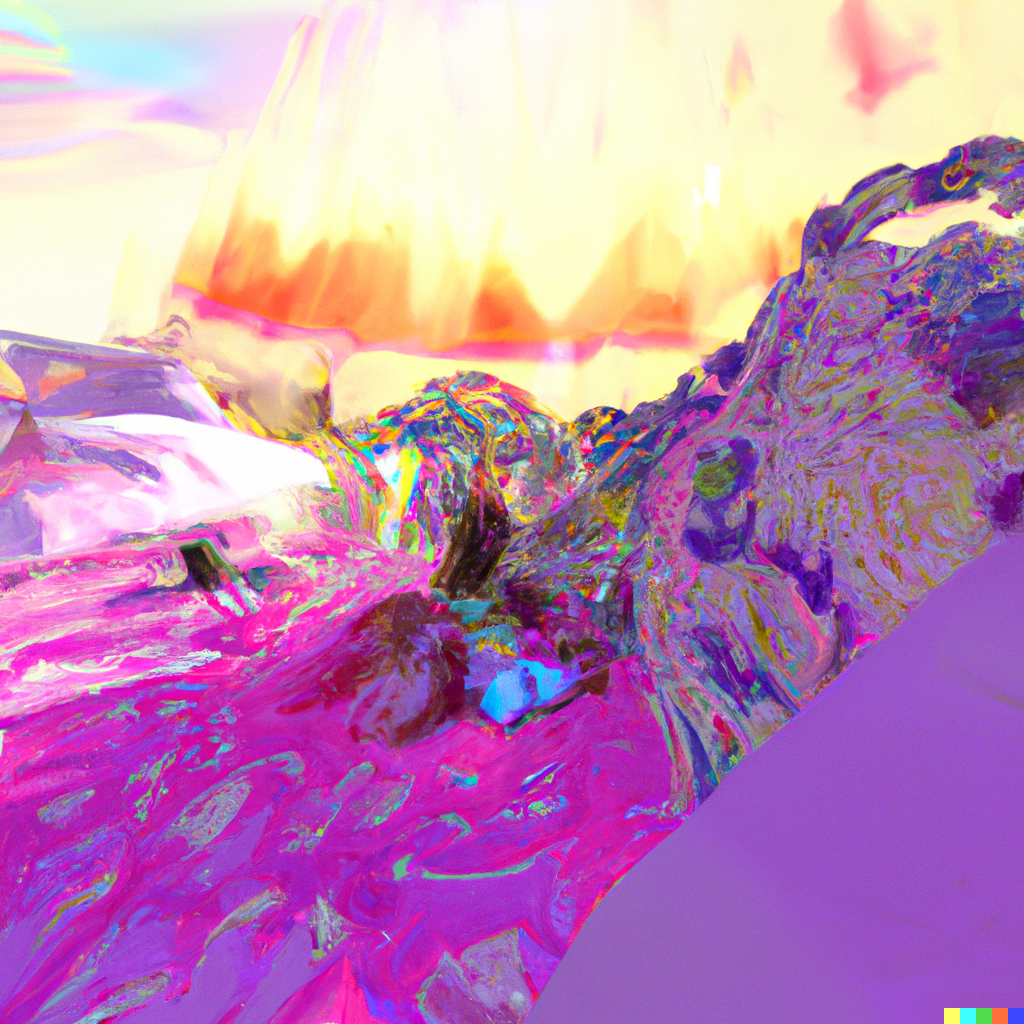

Cette dernière image m’a assez marqué car elle ajoute des effets de matières de réfractions multicolore et de lumières de sorte d’aurores boréales qui n’était pas présente dans l’univers.

Cela m’a donc donné envie de continuer d’expérimenter des effets matières, qui dans un univers de jeu vidéo en 3d s’appelle des shaders.